Zauber und Gefahr von Deepfakes: Fakevideos mit Missbrauchpotenzial

Deepfakes mit Kim Kardashian und Mark Zuckerberg sorgen für Aufsehen. Können wir bald unseren eigenen Augen und Ohren nicht mehr trauen?

Im Deepfake wirkt Mark Zuckerberg sogar authentischer als in echten Videos Screenshot: Instagram

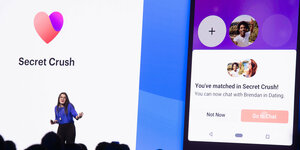

Facebook-Chef Mark Zuckerberg hat sich in einem Video zum Weltherrscher erklärt. Wie so häufig sitzt er mit einem grauen T-Shirt bekleidet in einem Büro und sagt: „Stellt euch das mal kurz vor: Ein Mann, mit totaler Kontrolle über die gestohlenen Daten von Milliarden Menschen, allen ihren Geheimnissen, ihr Leben, ihre Zukunft – ich schulde das alles Spectre. Spectre hat mir gezeigt, dass derjenige, der die Daten kontrolliert, auch die Zukunft kontrolliert.“

Die Lippenbewegungen passen zum Ton und die News-Bauchbinde mit dem Logo des US-amerikanische Nachrichtensenders CBS lassen das Video real erscheinen. Doch Zuckerberg hat dies so nie gesagt. Das Video ist ein sogenannter Deepfake. Die Wortschöpfung besteht aus „Deep Learning“, einem Teilbereich der künstlichen Intelligenz (KI), und „Fake“, also Fälschung.

Bezeichnet werden so mit Audio- und Videomanipulationssoftware produzierte Videos, in denen ein Algorithmus ein Gesicht in ein anderes reinmorphen kann. So kann Mark Zuckerberg in einem Video eine Rede halten, die er nie gehalten hat – und es sieht täuschend echt aus.

Die britischen Künstler Bill Posters und Daniel Howe haben vergangene Woche nicht nur das Zuckerberg-Deepfake bei Instagram hochgeladen, sondern auch Videos von Donald Trump und Kim Kardashian. Die Reality-TV-Darstellerin und Unternehmerin erklärt darin, dass sie unfassbar dankbar dafür sei, Menschen im Netz manipulieren zu können, um damit reich zu werden. Die Videos gehören zum Kunstprojekt „Spectre“. Der Name bezieht sich auf Sicherheitslücken in Computer- und Handy-Mikroprozessoren, die im Januar 2018 öffentlich wurden.

Gefährlicher Spaß

Wer genau hinsieht und zuhört, kann erkennen, dass sich bei den Videos nicht um reale Aufnahmen handelt. So ist beispielsweise nicht Zuckerbergs echte Stimme zu hören, und alle Videos sind mit dem Hashtag #deepfake versehen. Zudem sind die Aussagen der drei Prominenten so abstrus, dass vielen Instagram-Nutzer*innen vermutlich schnell Zweifel aufkommen. Doch verfälschte Ton- und Videoaufnahmen können nicht nur der Unterhaltung dienen, sondern auch Einfluss auf die aktuelle politische Weltlage nehmen.

Man stelle sich beispielsweise vor, was passieren würde, wenn eine russische Trollfabrik ein Deepfake produziert, in dem Donald Trump einen Krieg gegen Nordkorea ankündigt. Expert*innen warnen daher immer wieder vor dem hohen Missbrauchspotenzial dieser Fakevideos. EU-Justizkommissarin Věra Jourová wies im Zuge der EU-Wahl auf Gefahren von manipulierten Videos mit Politiker*innen hin. Können wir also bald unseren eigenen Augen und Ohren nicht mehr trauen, wenn es darum geht, was real und was Fake ist?

Im Europawahlkampf haben gefälschte Videos zwar keine große Rolle gespielt. Das aktuelle Trump-Video allerdings ist nicht das erste Video, in dem Politiker*innen Sachen von sich geben, die sie – zumindest in der Öffentlichkeit – nie geäußert haben.

Vergangenen Monat ging ein Video der Sprecherin des US-Repräsentantenhauses Nancy Pelosi viral, in dem sie scheinbar betrunken bei einer Veranstaltung spricht. Doch Pelosi war nicht betrunken, stattdessen hatte jemand die Abspielgeschwindigkeit des Videos reduziert und die Tonhöhe angepasst. Ein Eingriff, der mit jedem gewöhnlichen Computer sehr einfach möglich ist.

„Präsident Trump ist ein totaler und kompletter Idiot“

Bei einem zweiten Beispiel war schon etwas mehr Aufwand nötig: Ein Mann, der aussieht wie Barack Obama und spricht wie Barack Obama, sitzt in einem Büro, hinter ihm die US-amerikanische Flagge, und sagt: „Präsident Trump ist ein totaler und kompletter Idiot.“

Die Stimme gehört allerdings nicht wirklich Obama, sondern dem Schauspieler Jordan Peele. Mithilfe der FakeApp, die frei im Internet verfügbar ist, hat Buzzfeed im Jahr 2018 das Video erstellt, dabei wurde die Mundpartie Peeles über die von Obama gelegt. Laut Buzzfeed hat die Produktion 56 Stunden in Anspruch genommen.

Trotz dieser Beispiele bewertet der Medienanalyst Alexander Sängerlaub, der sich in der Stiftung Neue Verantwortung mit Desinformationen beschäftigt, die Lage als nicht sonderlich dramatisch: „Obwohl Deepfakes technisch immer besser werden, glaube ich noch lange nicht, dass unsere Art und Weise, wie wir die Realität verstehen und sehen, zusammenbricht.“ Momentan sei vor allem der zeitliche und technische Aufwand noch zu groß. Da eine hohe Rechenleistung erforderlich sei, dauere es zwischen 12 und 72 Stunden, um ein wenige Sekunden langes Video zu erstellen.

Als Beispiel für seine eher entspannte Haltung gegenüber Deepfakes führt Sängerlaub das Beispiel des Fotojournalismus an. Heutzutage könne jeder mit dem Bildbearbeitungsprogramm Photoshop Bilder verändern. Trotzdem komme es nur selten vor, dass man es in der Berichterstattung mit gefakten Bildern zu tun habe. „Zudem werden Deepfakes bisher vor allem zu Unterhaltungszwecken genutzt: derzeit vor allem in der Pornoindustrie.“

Die Pornos mit Emma Watson

Vor zwei Jahren begann ein anonymer Reddit-Nutzer Pornovideos ins Internet zu stellen, in denen er die Köpfe von Schauspielerinnen wie Scarlett Johansson oder Emma Watson auf die Körper von Pornodarstellerinnen montierte. Andere Nutzer*innen griffen sein Verfahren auf und perfektionierten die Videos, sodass mit bloßem Auge nicht mehr erkennbar war, dass es sich um eine Fälschung handelte. Für die Betroffenen kann das zwar gravierende Folgen haben, eine politische Gefahr ist es jedoch nicht.

Auch Pornovideos wurden schon gefälscht

Harmloser geht es beim „Face-Swap“ zu, verfügbar als eigene App oder als Funktion bei der vor allem bei jungen Leuten beliebten App Snapchat. Mithilfe von Algorithmen können die Nutzer*innen dort in Videos leicht Gesichter austauschen. So ist es beispielsweise möglich, dass man selbst auf Beyoncés Körper sitzt und zu ihrem Lied „Single Ladies“ tanzt.

Was hier spaßig angewandt wird, kann in einer technisch optimierten Form jedoch auch als potenzielles Desinformationswerkzeug genutzt werden. Wenn es um die Verbreitung von Deepfakes geht, tragen soziale Medien eine Verantwortung. So sind sowohl das Pelosi-Video bei Facebook als auch die „Spectre“-Videos bei Instagram noch online, obwohl es zahlreiche internationale Berichterstattungen über die Fakes gab.

Ein Pressesprecher von Instagram sagte auf Anfrage der taz: „Wir behandeln diese Inhalte so, wie wir alle Fehlinformationen auf Instagram behandeln. Wenn Faktenprüfer von Drittanbietern Inhalte als falsch markieren, dann filtern wir sie aus Instagrams Empfehlungsseiten wie Explore oder Hashtag-Seiten heraus.“ Sie werden dann zwar nicht mehr prominent angezeigt, aber auch nicht offline genommen. Dieses Verfahren hat bereits mehrfach zu kontroversen Diskussionen geführt.

Zu späte Faktenchecks

Denn einerseits verschaffen die Plattformen Desinformation damit Reichweite. Doch wenn Facebook & Co. anfangen würden, vermeintliche Fakevideos zu löschen, hätten sie die Entscheidungsmacht, was real und was Fake ist. Sängerlaub ist der Meinung, dass man dies im Einzelfall entscheiden müsste. Im Fall von Pelosi wurde bei Facebook ein Faktencheck unter das Video gepostet, in dem erklärt wurde, dass das Video verlangsamt wurde.

„Wenn jemand Desinformation produziert und ein paar Tage später ein Faktencheck dazu erscheint, ist das Video längst um die Welt gegangenen. Doch das lässt sich heute nicht mehr rückgängig machen, dass Dinge erstveröffentlicht und erst im Nachhinein verifiziert werden“, sagt Sängerlaub.

Wenn das Löschen der Videos Gefahren birgt und Faktenchecks meist zu spät kommen: Was kann im Umgang mit Deepfakes helfen? Sängerlaub plädiert in erster Linie dafür, die Medienkompetenz der Nutzer*innen zu fördern. Man müsse Deepfakes erklären und die Nutzer*innen dazu zubringen, Videos zu hinterfragen. Also: Welchen Quellen kann ich vertrauen? Gibt es das Video noch an anderer Stelle? Wie schätzen journalistische Medien es ein?

Deepfakes werden uns in Zukunft vermutlich häufiger begegnen. „Ich glaube, wenn Deepfakes immer weiter professionalisiert werden, sind auch die Nutzer*innen so weit mit der Technologie vertraut, dass sie einen Umgang damit finden“, sagt Sängerlaub. Doch nicht nur Nutzer*innen müssen geschult werden, sondern auch digitale Medien.

Deep Learning

Viele Forscher*innen, einschließlich der Gesellschaft für Informatik, plädieren generell für ein digitales Wasserzeichen, das Medien nutzen könnten. Somit könnte die Echtheit von Datenmaterial geklärt werden. Das Wasserzeichen müsste dabei mit dem Material verwoben werden, so dass es unmöglich sei, es zu entfernen, ohne das Datenmaterial zu beschädigen.

Der Informatiker Matthias Nießner der Technischen Universität München hat gemeinsam mit anderen Forscher*innen eine Datensammlung namens FaceForensics angelegt, worin sich eine Vielzahl gefälschter Videos und Hunderttausende Bilder finden. Daraufhin wurde ein Deep Learning System trainiert, das nun Unterschiede zwischen Originalen und Fälschungen erkennen soll.

Obwohl Deepfakes bisher nicht gegen die Richtlinien von Instagram verstoßen, könnte zumindest das Video von Mark Zuckerberg bald verschwinden. Der Nachrichtensender CBS forderte Facebook auf, das Video offline zu nehmen, da sein Logo ohne Genehmigung benutzt worden sei.

Leser*innenkommentare

Lowandorder

Na bitte - Geht doch

”…Obwohl Deepfakes bisher nicht gegen die Richtlinien von Instagram verstoßen, könnte zumindest das Video von Mark Zuckerberg bald verschwinden. Der Nachrichtensender CBS forderte Facebook auf, das Video offline zu nehmen, da sein Logo ohne Genehmigung benutzt worden sei.“

Dahin läuft also der Hase ins Pfeffer.

Nö. Kein Deepfake 😈

Na Mahlzeit 👹

Lowandorder

@Lowandorder & Däh&Zisch - Mailtütenfrisch -

“RE: Wiedervorlage Deep Throat -

"Wir brauchen mehr Verbotsparteien..."

Warum sollte sich Zuckerberg zum Weltenherrscher ausrufen?

Seine Kunden haben ihn doch längst als solchen akzeptiert.“

kurz - Einfaltspinsel = Ausfallspinsel •

(by Thomas Kapielski - einst 👹 taz )