Algorithmen und Diskriminierung: Maschinelle Sittenwächter

Plattformen wie Instagram und Tiktok löschen Fotos von dicken Menschen, die „zu viel“ nackte Haut zeigen. Das befeuert die Diskriminierung.

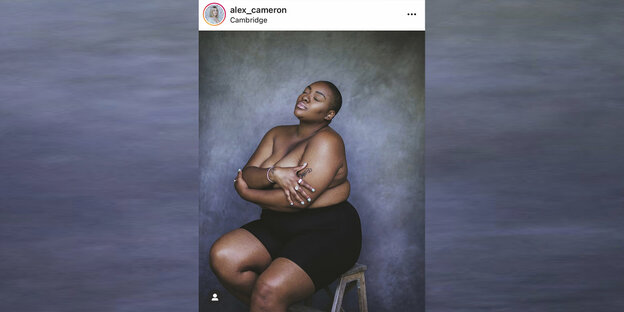

Der Algorithmus sah beim Model Nicholas-Williams „zu viel Haut“ Foto: alex_cameron/instagram/Screenshot taz

Vergangenes Jahr veröffentlichte das Model Nyome Nicholas-Williams eine sinnliche Aufnahme: die Augen geschlossen, der Kopf in den Nacken gelegt, die Arme um die Brust verschlungen. Die UserInnen waren begeistert.

Doch Instagram gefiel diese Pose nicht: Das Netzwerk löschte dieses und weitere Fotos und drohte Nicholas-Williams mit der Schließung ihres Accounts. Der Grund: Ein Verstoß gegen die „Gemeinschaftsrichtlinien“. Darstellungen von Nacktheit sind auf der Fotoplattform nicht erwünscht.

Nicholas-Williams machte das wütend. „Jeden Tag findet man auf Instagram Millionen von Bildern sehr nackter, dürrer weißer Frauen. Aber eine dicke schwarze Frau, die ihren Körper feiert, wird verbannt? Es war schockierend für mich“, sagte sie. „Ich fühle mich, als wäre ich zum Schweigen gebracht worden.“

Ein Aufschrei ging durchs Netz. Unter dem Hashtag „#IwanttoseeNyome“ riefen NutzerInnen Instagram dazu auf, das Foto wieder zu zeigen. Von Zensur und Rassismus war die Rede. Instagram entschuldigte sich für den Vorfall und änderte daraufhin seine Richtlinien.

Erst der Algorithmus, dann ModeratorInnen

Bei der Moderation seiner Inhalte setzt Instagram – wie auch der Mutterkonzern Facebook und andere Plattformen – auf eine Mischung aus künstlicher und menschlicher Intelligenz. Zunächst filtern Algorithmen den gröbsten Müll, dann sieben ModeratorInnen den Rest aus.

Zwar hat Facebook-Chef Mark Zuckerberg bei der Anhörung im US-Kongress 2018 vollmundig verkündet, ein KI-System könne problemlos Brustwarzen erkennen. Doch noch immer machen Computer haarsträubende Fehler. So wurden Zwiebeln als anstößig markiert, weil der Algorithmus die in einem Körbchen platzierten Knollen für die Rundungen eines Körperteils hielt.

Nach Angaben der Adult Performers Actors Guild, einer Gewerkschaft, die unter anderen SchauspielerInnen, Webcam-DarstellerInnen und StreamerInnen vertritt, meldet der Instagram-Algorithmus Fotos, auf denen über 60 Prozent Haut zu sehen ist – was in der Praxis dicke Menschen diskriminiert. Denn ein dicker Mensch hat eine größere Körperoberfläche als eine dünne Person und zeigt damit – bei gleicher Bekleidung – vergleichsweise mehr Haut. Die KI von Instagram hält das für obszön und schlägt Alarm.

Dass die Plattform Menschen mit anderen Proportionen diskriminiert, zeigt auch das Beispiel Celeste Barber. Die australische Comedian parodiert auf ihrem Instagram-Account regelmäßig die lasziven Posen von Topmodels.

Als Barber das Supermodel Candice Swanepoel imitierte und ihre Brust mit der Hand bedeckte, wurde das Foto mit dem Hinweis zensiert, dass der Post gegen die Richtlinien verstoße. Swanepoels Vorlage wurden von den algorithmischen Sittenwächtern dagegen durchgewinkt – obwohl das südafrikanische Topmodel noch viel spärlicher bekleidet war und nicht mal einen Stringtanga trug.

Misst Instagram hier mit zweierlei Maß? Sind Menschen, die nicht die Körpermaße von dünnen Models haben, nicht präsentabel? Auch hier könnte wieder der erratische Objekterkennungsalgorithmus eine Rolle gespielt haben. Barbers Brüste sind im Vergleich zu Swanepoels deutlich größer, also „sieht“ der Algorithmus mehr nackte Haut und daher einen möglichen Verstoß.

Doch anders als es uns die Softwareentwickler weismachen wollen, geht es hier nicht um statistische oder technische Details, sondern um die gesellschaftspolitisch relevante Frage, was wir sehen wollen und was nicht.

Instagrams Doppelmoral

Zur Nacktheit haben Techkonzerne ein zwiespältiges Verhältnis. Auf der einen Seite wirkt Instagram wie eine Modestrecke, wo sogar Protest zur Pose verkommt. Auf der anderen Seite fühlt man sich zuweilen wie in einem puritanischen Regime, wo ständig die Moralpolizei patrouilliert und Kleidungsvorschriften kontrolliert.

So hat Facebook Fotos von Gustave Courbets berühmtem Gemälde „Der Ursprung der Welt“ und Abbildungen der „Venus von Willendorf“ verschämt aus seinen Galerien verbannt. Auch Fotos von nackten, in Ketten gelegten Aborigines wurden von Facebook mit Verweis auf die Nacktheitsgrundsätze gelöscht, was einen bizarren Fall von Cancel Culture markiert: Historische Dokumente der Sklaverei verschwinden kommentarlos von der Bildfläche.

Einmal programmiert, machen Algorithmen Tabula rasa. Das zeigt einmal mehr, dass der Rigorismus, der Algorithmen innewohnt und das binär codierte Weltbild, das keine Graustufen zulässt, mit den Werten einer offenen Gesellschaft nicht vereinbar sind.

Es sind aber nicht nur Maschinen, die unsere Werteordnung attackieren, sondern auch Menschen. So wurden ModeratorInnen der populären App Tiktok angewiesen, Videos von Menschen mit Behinderung zu verbergen. Wie Recherchen von netzpolitik.org zeigen, wurden in den Richtlinien als Beispiele Merkmale wie „entstelltes Gesicht“, Autismus oder Downsyndrom genannt. Auch queere und dicke Menschen sollten von der Bühne verschwinden. Begründet wurde die Reichweitenbegrenzung mit Mobbingschutz.

Für die Bewertung hatten die ModeratorInnen 15 Sekunden Zeit. Die berechtigte Frage ist natürlich, ob man in einer so kurzen Zeitspanne ferndiagnostisch Autismus erkennen kann. Und ob man Diskriminierung mit Diskriminierung bekämpft. Denn natürlich ist es diskriminierend, wenn Menschen aufgrund ihres Aussehens oder einer Behinderung benachteiligt werden. Sind dicke Menschen oder Menschen mit Behinderung nicht vorzeigbar? Wer definiert, was „normal“ ist?

Mit den Vorwürfen konfrontiert, räumte das Unternehmen ein, Fehler gemacht zu haben. Auf Anfrage von netzpolitik.org erklärte eine Sprecherin: „Dieser Ansatz war nie als langfristige Lösung gedacht und obwohl wir damit eine gute Absicht verfolgt haben, wurde uns klar, dass es sich dabei nicht um den richtigen Ansatz handelt.“

Die Regelungen seien inzwischen durch neue, nuancierte Regeln ersetzt worden. Man habe die Technologie zur Identifikation von Mobbing weiterentwickelt und ermutige die Nutzer zum positiven Umgang miteinander. Ein repräsentatives Bild unserer Gesellschaft lässt Tiktok allerdings weiterhin vermissen.

Solche kruden Selektionskriterien wecken böse Erinnerungen. Die paternalistische Annahme, dass man Mobbing im Netz nur verhindern könne, wenn man potenzielle Opfer aus dem Scheinwerferlicht der Öffentlichkeit und vermeintlich in Schutz nimmt, sagt viel aus über das Selbstverständnis der Plattform – und die Umgangsformen im Netz.

Der Kulturwissenschaftler Joseph Vogl beschreibt in seinem Buch „Kapital und Ressentiment“, wie die „Bewirtschaftung des Sozialen“ und „ballistische Schnellkommunikation“ das Ressentiment in der Gesellschaft befeuern. Es wurzele in einem „spezifischen Vergleichs- und Relationszwang, in einem Reflex zu Valorisierung und Bewertung, in einer wuchernden Urteilslust“, schreibt Vogl. So befördere die „Ökonomie des Ressentiments“ das Konkurrenzsystem und umgekehrt.

Aus einer mathematischen Norm wird eine soziale

Auf Plattformen wie Tiktok sind NutzerInnen systemisch gezwungen, ständig Bewertungen abzugeben, sonst sieht man keine neuen Inhalte. Hopp oder topp, Daumen hoch oder runter. Dieser Valorisierungszwang durch algorithmische Selektion erzeugt nach Vogl Konformismen, die wiederum „soziale Divergenzmächte“ stimulieren.

Im Fall von Instagram wäre dies der Algorithmus, der nach einer bestimmten statistischen Häufigkeitsverteilung (zu viel) Nacktheit bewertet – und aus einer mathematischen eine soziale Norm macht.

Und das wirkt sich über automatisierte Feedbackschleifen auch auf Schönheitsideale aus. Die 17-jährige Schauspielerin Sissy Sheridan twitterte: „Ich mochte meinen Körper, bevor ich Tiktok heruntergeladen habe.“ Studien belegen, dass durch das Scrollen durch Instagram-Feeds die Zufriedenheit mit dem eigenen Körper abnimmt.

Das Phänomen des „Body Shaming“ wird durch eben jene algorithmisch-biometrischen Screenings hervorgerufen, die dicken Models zu viel Freizügigkeit bescheinigen. Vielleicht bräuchte es auch in sozialen Netzwerken eine Kampagne wie die des Kosmetikkonzerns Dove, der schon 2004 mit dicken Frauen warb. Dann würden sich auch Models wie Nyome Nicholas-Williams wohler fühlen.

Leser*innenkommentare

05989 (Profil gelöscht)

Gast

Meiner Meinung hat das Problem hier zu wenige Dimensionen: Der Skinny-Bias kommt ja nicht nur durch (angenommene) Sehgewohnheiten, die dann durch KI perpetuiert wird, sondern ist auch einfach eine direkte Folge des Youth-Bias.

Natürlich gibt es auch junge Adipöse, aber in der Masse ist das eine Alterserscheinung - und Instragramm dürfte nur einen lächerlich geringen Nutzeranteil über 30 haben.

Will sagen: Das ist natürlich auch eine direkte Folge des Jugendwahns. Social Media gibt den vor und die alten Säcke des ÖR rennen dem hinterher, deswegen zeigt auch der ÖR im Wesentlichen schöne, junge, schlanke Menschen.

Diversität ist mittlerweile ein Problem einer adäquaten Darstellung nicht nur der Geschlechter, sondern auch der Repräsentation von Alter, BMI, sozialem Status (es wohnen tatsächlich nicht alle Deutschen in weiß getünchten Einfamilienhäusern mit PV-Anlage am Dach), Migration...

Und unsere gefühlte Wirklichkeit bemisst sich dann eben doch - da sind wir immer noch ganz Homo Erectus - an der Wirklichkeit, die wir (medial) konsumieren. Es kostet viel Energie, das jeden Tag zu reflektieren - und die bringen die Wenigsten auf.

Es braucht viel, viel mehr mediale Formate wie zum Beispiel "B12 - Gestorben wird im nächsten Leben". Auch die Lindenstraße wahrte noch eine gewisse Ästhetik, obwohl sie immerhin schon der gerade linke Versuch war, mehr Realität zu wagen.

Da möchte ich noch eine Anekdote loswerden: Ich war 2001 in Mexiko und da lief an der Bar den ganzen Tag der Fernseher mit mexikanischem Programm. Da waren aber keine Mexikaner, schon gar keine Indios zu sehen, sondern ausschließlich ziemlich Hellhäutige, die man sogar in den USA nicht als Latinos identifizieren würde. Auch Japan gehört zu einer der ältesten Gesellschaften der Welt - aber im Fernsehen ist kaum einer über 40.

Mondschaf

Siri Li Siri La Siri Lum.

smartphone-Nutzer werden dumm.

Auch die Nutzerinnen

können nicht entrinnen.

Fast alle nutzen die "KI"

und fragen nur ganz selten wie

das Ganze denn so vor sich geht.

Wenn mensch gar nichts mehr versteht

ist es sicherlich zu spät.

sachmah

Komisch. Dabei ist der (menschengemachte) Algorithmus schneller angepasst als irgendein Jurist eben fahren lassen kann. Als Konzern einfach mal schnell reagieren statt peinliche Debatten zu führen.

tomás zerolo

Spannender Artikel, obwohl ich mit so manchem nicht einverstanden bin.

Dieser nebulöse Verweis auf "Algorithmen" -- es handelt sich hier --vermutlich-- durch die Bank um machine learning ist nicht nur ungenau, sondern verhüllt die Sache in einem mystischen Schleier, was für eine Kritik kontraproduktiv ist.

Ungenau, weil es sich hier in erster Linie um statistische Modelle handelt, die irgendwelchen "Trainingsdaten" angepasst werden (und das, ja, vermittels Algorithmen). Die Trainingsdaten, nun ja, die kommen von "da draussen" und werden bewertet, entweder explizit, oder man kriegt die Plattformnutzer*innen dazu, es für einen zu tun (vgl. o.a. Beispiel mit TikTok).

Verschleiert, weil es die Tatsache verbirgt, dass sie letztlich nur die Unzulänglichkeiten spiegeln, die wir in die Trainingsdaten stecken.

Daher fokussieren wir uns auf die Fälle, in denen die Modelle danebenlangen (Zwiebeln, nackte Haut, haha). Das ist lustig (finde ich auch :-) -- verdeckt aber das eigentliche Problem: mit der Maschine kann ich nicht diskutieren. Die wird gerade deshalb eingesetzt, weil Menschen zu teuer sind! Da gibt es kein*e Ansprechpartner*in, und das mit Absicht. Friss oder stirb.

Das Geschäftsmodell von Instagram & Co würde gar nicht aufgehen, wenn am anderen Ende jemand wäre, die ich anmailen kann: "hey, Du hast mein Bild runtergenommen, warum?".

Meine persönliche Lösung? Ich brauche die alle nicht. Nicht Facebook, nicht LinkedIn, nicht Instagram oder TikTok, Google und Youtube gehe ich aus dem Weg; selbst das eine oder andere Tweet schaue ich mir auf Alternativkanälen (Nitter) an. Neu auf der schwarzen Liste: Github. Ich klone ein Repo, aber ansonsten fasse ich die nur mit Gummihandschuhen an.

Doof, aber die ekeln mich alle an.

Lowandorder

@tomás zerolo Vor allem - wie sich hier wieder zeigt:

ES GIBT KEINE KÜNSTLICHE INTELLIGENZ • (Begriff erfunden: - um besser an Staatsknete zu kommen!

Nothing else!;)(( bei Heinz von Foerster & Cie. mal nachlesen - wie‘s gefingert worden ist + vollmundige 💨 💨💨💨 - Versprechungen der Entwicklung - wa!

C.O.Zwei

Das Foto überzeugt mich. Auch mit wenig Kleidung kann man bei vielen Gelegenheiten gut aussehen.

Stefan L.

Klar, ungerechte oder unsensibel Bildlöschungen und fehlerhaft agierende Algorithmen auf Social Media Portalen sind vielleicht ärgerlich aber die Nutzung ist doch freiwillig.

Wenn mir der Umgang mit Bildern auf TikTok oder Instagram nicht passt, poste ich da nicht - zumal es völlig unwichtig und der Hausherr ein Privatunternehmen ist.

Ungerechte Bildlöschungen kann man ja wohl kaum mit Zensur von Nachrichtenmedien in Diktaturen vergleichen.

Mal wieder ein echtes First World Problem.

Obscuritas

@Stefan L. Seien Sie froh das Sie auf die Reichweite der Sozial Media Platformen nicht angewiesen sind.

Leider sind die Plattformen in Ihrer Stellung praktsich ein Monopol, so dass Menschen auf diese angewiesen sind.

Schauspiel, Musik, Kunst, Mode.

Wer in diesen Branchen Tätig ist und öffentliche Aufmerksamkeit benötigt, kommt einfach nicht ohne die Plattformen aus.

Aufmerksamkeit und Reichweite stehen in direktem Zusammenhang mit Erfolg für manche Berufe und somit auch Einkommen.

Wenn Sie als Privatperson in Ihrem Beruf darauf nicht angewiesen sind, gut für SIe, Sie haben Recht es ist eine freie Entscheidung für Sie.

Das gilt aber nicht für alle und SIe sollten auch nachvollziehen können welche Veränderung Social Media für viele Berufe gebracht hat, ganz zu schweigen von denen die durch Social Media erst entstanden sind.

Und auch für viele Menschen, die nicht beruflich davon abhängen ist Social Media ein wichtiger Teil Ihrer soialen Kommunikation geworden. Alternativen zu den großen Plattformen gibt es nicht.

Stefan L.

@Obscuritas "Seien Sie froh das Sie auf die Reichweite der Sozial Media Platformen nicht angewiesen sind...."

Ich bin freiberuflicher Illustrator und Grafiker und nutze tatsächlich Instagram zur Präsentation meiner Arbeiten. Ich poste aber ausschliesslich Illustrationen, Malerei und Design und hatte noch nie Probleme. Ich zeige auch nicht meinen nackten Hintern, mein Mittagessen oder meine eingewachsenen Fußnägel.

Jeder der Social Media nutzt, sollte sich einfach an die Regeln halten. Man kann sie ja für blöd halten, ich glaube aber kaum, dass sie Karrieren von kreativen Freiberuflern verhindern, nur weil man keine Brustwarzen oder zu viel nackte Haut zeigen kann.

97760 (Profil gelöscht)

Gast

@Stefan L. ..so sieht's aus. Was die user alles einfordern, wirkt schon infantil. Berufen sich beispielsweise auf Meinungsfreiheit, wenn ein privater Medienbetreiber, kann auch ein "Einmannbetrieb sein, gewisse Meinungen oder Bilder, eben nicht veröffentlicht.

Paul Rabe

Den Konzernen ist es natürlich völlig egal.

Sie stehen nur in dem Spannungsfeld von verschiedenen Moralvorstellungen und haben das Problem dass man in der Flut von Milliarden von Bildern nicht jedes Bild von einem Menschen begutachten lassen kann.

Vielleicht sollten wir als Gesellschaft insgesamt wieder zurück zu der Idee, dass zusätzliche Information an sich erst mal nicht schlecht ist.

Man nicht den Sender sondern den Empfänger dazu ermutigt Informationen sinnvoll zu verarbeiten und wenn mir ein nacktes Bild nicht gefällt, dann ignoriere ich es eben.

Das Prinzip sollte man übrigens auch bei ungewollten Begriffen oder Wörter anwenden, wem etwas nicht gefällt, der soll es einfach ignorieren

92293 (Profil gelöscht)

Gast

Man läßt sich auf Konfrontationen ein die man ohne diese digitales nicht hätte, mehr als 20 Morddrohungen mußte ich ‚auswuchten‘ Polizei fand das lediglich nur unbedeutend ….. seit mehr als 5 Jahren nutze ich dieses unzulängliche Kommunikationstool nicht mehr …. Es ist zu fehlerbehaftet und sollte nicht am Markt sein. TÜV fürs Internet wurde mal gefordert, die Bürger fühlten sich gegängelt

Bolzkopf

Die Überlegungen dahinter sind doch nachvollziehbar simpel:

- So lange die Fehlerquote nicht zu groß ist, hat es keine (negativen) Auswirkung auf den Unternehmenserfolg (vulgo: -gewinn)

-So lange es nur Minderheiten betrifft, hat es keine (negativen) Auswirkung auf den Unternehmenserfolg (vulgo: -gewinn)

- So lange Fehler folgenlos bleiben (also keine juristischen Sanktionen drohen) sind sie hinnehmbar

- Menschen zur Filterung einzusetzen muss ja nicht unbedingt die Fehlerquote verbessern - aber es ist in jedem Fall teurer.

- Nichts wäre schlimmer, als wenn ein zu beanstandender Inhalt "durchflutscht" und zu Ärger mit den Werbetreibenden führt - also lieber "auf Nummer sicher" gehen.