Medienkunstfestival Ars Electronica: Auf schwankendem digitalen Grund

Die Ars Electronica in Linz war einst technikbegeistert. Jetzt zeigte sie sich technikkritisch. Es geht um Wahrheit und künstliche Intelligenz.

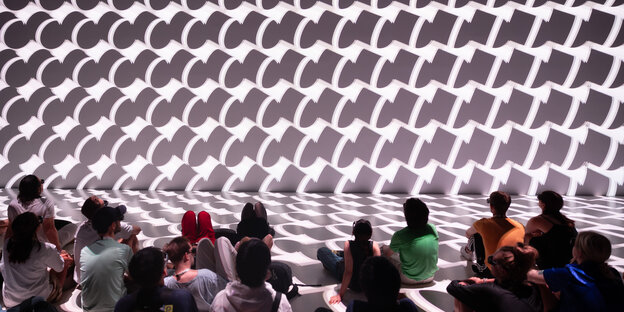

Installation von Toyota Coniq Alpha, Akiko Nakayama, Quadrature und Akira Wakita Foto: Tom Mesic

„Wem gehört die Wahrheit?“, fragte mit sanftem Sinn für Provokation die gerade zu Ende gegangene Ausgabe des Medienkunstfestivals Ars Electronica in Linz. Sanft ist die Provokation vor allem deshalb, weil die Postmoderne den Begriff „Wahrheit“ längst entsorgt hat, mit dem Hinweis darauf, dass Erkenntnis stets an die Perspektive der Betrachter gebunden sei. Demzufolge ist so etwas wie „Wahrheit“ bestenfalls relativ.

In den letzten Jahren hatten allerdings zu viele „alternative Wahrheiten“ Konjunktur, sodass der Ruf nach allgemein verbindlichen Standards lauter wurde. Heute, da generative künstliche Intelligenzen massenhaft Texte, Bilder und Videos erzeugen können, die echt scheinen, aber eben nicht echt sind, erlebte der Wahrheitsbegriff schließlich eine Renaissance.

Das Problem der „deep fakes“ wurde daher zu einer Programmlinie des traditionell zwischen Technologie, Kunst und Philosophie mäandernden Festivals. So wurde noch einmal das „Obama Deep Fake“ ausgestellt, jenes vom US-Regisseur Jordan Peele mithilfe von AI-Tools erstellte Video einer Obama-Rede, die der US-Präsident nicht hielt. Peele ließ vielmehr die von ihm eingesprochene Rede auf die Gesichtszüge des früheren US-Präsidenten applizieren, mittels KI.

Auch das Putin-Pendant, mithilfe der Software face2face erstellte Grimassen, die Forscher des Visual Computing Lab der TU München auf das Gesicht von Wladimir Putin aufbrachten, ist im Ausstellungsparcours „Understanding Artificial Intelligence“ im Ars Electronica Center enthalten. Sich vor „deep fakes“ zu schützen, ist gar nicht so einfach. Fehler, an denen man sie erkennen kann, wie seltsame Pixelkonstellationen oder Hände mit sechs Fingern, wie sie manche frühe KIs errechneten, werden immer seltener.

Wie Algorithmen operieren

Die Gefahr, einer Fehlinformation aufzusitzen, erhöhe sich, je plausibler das in Text und Bild Gesagte erscheint, betonte der für die Eröffnungsrede eingeladene Wikipedia-Gründer Jimmy Wales. Programme wie ChatGPT seien nicht in der Lage, vernünftige Wikipedia-Artikel zu erstellen. Denn die Algorithmen operierten nicht auf der Basis von Fakten, sondern durchforsteten das Datenmaterial vor allem mit dem Ziel, einen dem Auftrag am wahrscheinlichsten entsprechenden Text zu erstellen.

Das führe systematisch zu frei erfundenen, aber überzeugend wirkenden Quellen und echt scheinenden, aber nicht mit Informationen unterlegten Internet-Links. „Am gefährlichsten sind nicht die deep fakes, die völlig verrückt klingen, sondern die, die uns plausibel vorkommen, aber dennoch Falschinformationen enthalten“, warnte Wales.

Die Ars Electronica ließ aber nicht nur die Alarmsirenen schrillen. Die Ausstellungen im Ars Electronica Center und dem sehr imposanten Gebäudekomplex der Post City mit den riesigen Paketrutschen gaben sich auch ganz den neuen Möglichkeiten hin. So wurde KI vorgestellt, die im Stile Beethovens komponieren oder eigene Lieder singen kann. Warner Music hat sogar schon eine App – die in Berlin entwickelte Kompositionssoftware Endel – mit einem Plattenvertrag ausgestattet, erfuhr man.

Wem gehört die Wahrheit?

In der Programmlinie Data Art & Science werden Daten zu visueller Kunst verarbeitet. „Mother Fluctuation“ des japanischen Künstlers Akira Wakita etwa verknüpft Klimawandel-relevante Statistiken zu Temperatur und Meeresspiegel mit dem IPCC-Bericht zum Abschmelzen der Gletscher und erzeugt dabei gigantische digitale Wellen, die auf den Betrachter zurasen.

Wem eigentlich die Daten gehören, aus denen Wahrheit(en) generiert werden, erläuterte Stefano Rossetti, Datenschutzanwalt beim Europäischen Zentrum für digitale Rechte, bei einem Vortrag: Im Juni wurden Datenleaks bei Xandr bekannt. Die Analysefirma und Microsoft-Tochter erstellt Nutzerprofile, bei denen Personen unter anderem nach ihrer Einstellung zu Abtreibung oder zu Donald Trump, ihrem Surf- und Einkaufsverhalten („digitale Süchtige“ bzw. „Mütter, die wie verrückt shoppen“) charakterisiert werden. All das wird selbstverständlich auch verkauft.

Mag man über die personalisierte Werbung noch lächeln, so stellt sich dennoch die Frage nach dem Eigentum der Daten in ganz neuer Schärfe, wenn etwa Arbeitgeber Bewerber*innen damit durchleuchten oder Aufenthaltsgenehmigungen, Mietverträge und Sozialleistungen auf der Basis solcher Daten gegeben, wenn nicht, verweigert werden.

Befriedigende Antworten bot die Ars Electronica nicht. Das ist auch nicht die Aufgabe von solchen Kunstprojekten. Wichtige Fragen allerdings wurden in den Raum geworfen. „Wem gehört die Wahrheit“ ist eines der aktuell wohl wichtigsten globalen Problemfelder.